新质生产力引擎:大语言模型的原理与应用

作者: 杨磊

摘要:在人工智能时代,新质生产力正成为推动社会发展的关键力量,大语言模型作为其中的重要组成部分,尤其在自然语言处理领域的突出表现,正引领新一轮的技术革新。本文向读者介绍了大语言模型的基本原理、训练过程及其在多个行业的应用,展示这一技术如何提升工作效率、优化决策和改善服务体验,同时也探讨了大语言模型面临的挑战,并展望其在未来社会发展中的潜力。通过本文的介绍,希望能激发更多的人对这一领域的兴趣,共同促进大语言模型技术的发展和应用,为社会进步贡献力量。

关键词:新质生产力;大语言模型

今年,政府工作报告将“大力推进现代化产业体系建设,加快发展新质生产力”列为首要任务,彰显了政府对经济发展的深刻理解和未来趋势的敏锐把握。新质生产力代表了一种以科技创新为核心,推动产业转型升级和经济增长质量提升的先进生产力形态。它强调通过科技进步,特别是信息技术和人工智能的发展,来提高全要素生产率,实现经济的可持续和高质量发展。在这个框架下,大语言模型作为人工智能领域的一项关键技术,发挥着至关重要的作用。这些模型利用深度学习和神经网络,尤其是Transformer架构,来处理和生成自然语言,从而在多个行业中实现高效的语言理解和交流。大语言模型的应用不仅提升了工作效率,优化了决策流程,还改善了用户体验,推动了产业链供应链的优化升级。可见,新质生产力的发展离不开大语言模型这一强大的技术支撑,而大语言模型的进步又不断推动新质生产力向前发展。本文将以ChatGPT为例,介绍大语言模型的基本原理、训练过程及其在多个行业的应用。

ChatGPT的崛起与大模型时代的开启

在人工智能发展的漫长历程中,ChatGPT的出现无疑是一个分水岭,它不仅引领了自然语言处理技术的飞跃,更宣告了大模型时代的到来。这一技术突破的背后,是几十年来科学家对模拟人类智能的不懈追求和探索。早期的人工智能研究集中在简单的模式识别和基于规则的系统上,这些方法在处理结构化数据时表现尚可,但在自然语言的复杂性和多样性面前却显得力不从心。随着时间的推移,研究者开始意识到,要让机器真正理解语言,就必须赋予它学习和适应的能力。这一理念的转变,为深度学习技术的兴起铺平了道路。

在人工智能的早期,艾伦·麦席森·图灵提出了著名的图灵测试,为人工智能的发展奠定了理论基础。1966年魏茨鲍姆的ELIZA聊天机器人问世,虽然它只能进行简单的模式匹配,但它开启了人工智能对话系统的新篇章。随着技术的进步,聊天机器人Jabberwacky由英国程序员罗洛·卡彭特于1988年创建,它试图通过模拟人类的自然聊天来提供有趣、娱乐的互动体验。互联网的兴起为人工智能提供了丰富的数据资源,聊天机器人ALICE是一种通用语言处理的聊天机器人,它使用启发式模式匹配来进行对话。它的诞生标志着对话系统进入了一个新的发展阶段。然而,早期的聊天机器人受限于模式匹配和简单的语言规则,直到深度学习技术的兴起,人工智能对话系统才迎来了真正的突破。

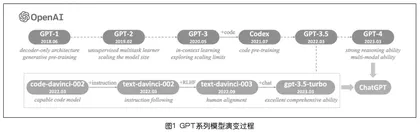

深度学习是一种模仿人脑神经网络结构的机器学习技术,通过大量数据的训练,使得机器能够从大量数据中学习语言的复杂规则和模式,从而生成更加自然、流畅的对话。21世纪初,随着计算能力的显著提升和大数据技术的普及,深度学习开始在图像识别、语音处理等领域取得显著成果,为语言模型的发展提供了新的可能性。在这样的技术背景下,语言模型的研究迎来了革命性的变化。2013年,Word2Vec模型的出现为后续的语言模型发展奠定了基础,它通过学习大量文本数据生成词的向量表示,捕捉词之间的语义关系。紧接着,Google的研究者提出了Transformer架构,它通过自注意力机制让模型能够同时考虑句子中的所有词,显著提高了处理长距离依赖关系的能力。2018年,OpenAI发布了基于Transformer架构的GPT模型,这是第一个成功使用这种架构的大型语言模型,它不仅能够生成流畅自然的文本,还能够理解和回应用户的输入。GPT模型天然能够应对自然语言生成问题,并且具备了一定的通用语义表示能力,也是后续OpenAI公司发布的GPT系列模型的雏形,包括GPT-2、GPT-3、ChatGPT和GPT-4等,GPT系列模型的演变过程如图1所示。随着GPT模型系列的不断迭代和优化,从GPT-2到GPT-3,模型的参数量和性能都有了显著提升。这些模型通过在海量文本数据上进行预训练,学习到了丰富的语言知识,然后在特定任务上进行微调,以适应各种语言处理任务。其中ChatGPT作为GPT-3的一个应用,专门针对对话生成进行了优化,能够进行自然的对话交流。这一成就不仅是技术上的突破,也是对人类智能的一次致敬,证明了通过深度学习和神经网络,可以构建出能够理解和生成自然语言的复杂系统。

ChatGPT的诞生不仅是技术上的突破,也是对人类智能的一次致敬。它证明了我们可以构建出能够理解和生成自然语言的复杂系统。这一成就不仅为人工智能领域带来了新的可能,也为未来的科技发展和人类社会的进步提供了无限的想象空间。大语言模型很快成为社会各界关注的焦点,并被视为通往通用人工智能的可能途径。笔者按照时间线总结了2019年至2023年5月间比较有影响力并且模型参数量超过100亿的大语言模型(如下页图2)。

大语言模型及ChatGPT的工作原理

在探索大语言模型和ChatGPT的工作原理时,我们仿佛踏上了一段从数据清洗到机器学习的深入旅程。本文将逐步介绍这一过程,揭示这些技术如何共同作用,赋予机器生成和理解人类语言的能力。

1.数据清洗:模型学习的基础

在构建语言模型,尤其是像ChatGPT这样的高级AI系统时,数据清洗是整个过程中至关重要的一步。ChatGPT的训练涉及处理来自网络、书籍、新闻文章等多种来源的海量文本数据。这些数据集不仅规模庞大(通常达到数千亿单词),而且类型多样,包含了人类语言的广泛表达。然而,原始文本数据通常包含噪声和不相关的信息,如HTML标签、特殊字符、不完整的句子等,这些都需要在预处理阶段被清除或转换为模型能够理解的格式。此外,数据集中可能存在大量重复内容,需要通过算法检测并删除,避免模型训练时的冗余。文本还需要规范化处理,如统一字符编码、进行分词、去除停用词、执行词干提取或词形还原,以减少数据集中的单词变化形式。为了减少模型学习中的偏见和不当内容,还需消除带有偏见、歧视或不适当内容的文本。进一步地,通过构建词汇表将每个单词或词素映射到唯一的数字或标识符,为构建词向量打下基础。最终,清洗后的数据集会被切分为训练集、验证集和测试集,以确保模型训练和评估的有效性。这一系列数据清洗和加工处理的步骤,为ChatGPT提供了坚实的学习基础,帮助模型提高泛化能力,确保生成文本的准确性和相关性。

2.词向量:语言的数学表达

词向量是自然语言处理(Natural Language Processing,NLP)中的核心概念,它将单词或短语转换为机器可理解的数学形式,即实数向量。这些向量能够捕捉单词之间的语义关系,使得模型能够理解单词的相似性、相关性甚至词义的变化。生成词向量的过程被称为词嵌入,它是Embedding技术在NLP中的具体应用。Embedding技术是一种更广泛的机器学习技术,它不仅用于文本,还可以用于图像、声音等其他类型的数据,通过将离散的、高维的数据转换为连续的、低维的向量表示,以便于机器学习模型的处理。作为实现Embedding技术的具体算法或计算框架,Embedding模型包括Word2Vec、GloVe、FastText等,它们通过不同的方法学习单词的语义和语法信息,生成能够反映单词特性的向量表示(如下页图3)。这些概念共同构成了NLP的基础,使得计算机能够更有效地理解和处理人类语言。

Word2Vec由Google开发,Word2Vec是一种生成词向量的模型,它使用两种算法——CBOW(Continuous Bag of Words)和Skip-gram来学习单词的向量表示。CBOW根据上下文预测目标单词,而Skip-gram则相反。Word2Vec模型能够捕捉单词之间的语义关系,生成的向量能够反映单词的相似性和差异性。

GloVe(Global Vectors for Word Representation)模型通过分析单词在语料库中的共现频率来学习词向量。它将共现概率矩阵转换为词向量之间的点积,通过迭代优化得到词的向量表示。GloVe的优点在于它能够在保持语义关系的同时,生成较小维度的词向量,适用于多种NLP任务。例如,将单词“king”的词嵌入(在维基百科上训练的GloVe向量)得到的结果是:

[ 0.50451 , 0.68607 , -0.59517 , -0.022801 , 0.60046 , -0.13498 , -0.08813 , 0.47377 ,-0.61798 , -0.31012 , -0.076666 , 1.493 , -0.034189 , -0.98173 , 0.68229 , 0.81722 , -0.51874 , -0.31503 , -0.55809 , 0.66421 , 0.1961 , -0.13495 , -0.11476 , -0.30344 , 0.41177 ,-2.223 , -1.0756 , -1.0783 , -0.34354 , 0.33505 , 1.9927 , -0.04234 , -0.64319 , 0.71125 , 0.49159 , 0.16754 , 0.34344 , -0.25663 , -0.8523 , 0.1661 , 0.40102 , 1.1685 , -1.0137 , -0.21585 , -0.15155 , 0.78321 , -0.91241 , -1.6106 , -0.64426 , -0.51042 ]。

这个向量是一个50维的实数数组,每个数字代表了“king”在GloVe模型的向量空间中的一个坐标值。

FastText由Facebook AI Research开发,FastText是一种考虑了单词内部结构的词嵌入技术。它将单词表示为字符n-grams的集合,并同时学习单词和n-gram级别的表示,这使得FastText能够有效处理不同形态的单词,包括未登录词和稀疏词。FastText还支持多语言文本数据,并以快速的训练和推断速度而闻名。

这些传统的词嵌入方法通过学习单词的内在含义和它们之间的相关性,为机器学习模型提供了一种强大的工具,以处理和分析大规模的文本数据。随着技术的不断进步,这些方法在理解语言的深度和准确性上不断取得突破,极大地推动了自然语言处理领域的发展。在ChatGPT这样的大语言模型中,词向量的生成通过预训练的Transformer架构实现,该架构包括分词、可训练的embedding层、位置编码以及自注意力机制。这些技术使得模型能够学习到丰富的语言特征,并生成上下文相关的词向量,其中,每个token的表示会根据其在句子中的上下文而变化。此外,通过微调,模型能够进一步适应特定的任务需求。与传统的词嵌入方法相比,ChatGPT的上下文感知词向量能够更准确地捕捉语言的细微差别和长距离依赖关系。Embedding技术的价值体现在其降维能力、捕捉语义信息、适应性、泛化能力和可解释性上,这些特性共同推动了NLP领域的发展,并在多个行业中提高了语言理解和交流的效率,成为推动新质生产力发展的重要技术之一。

3.语言模型的演变:Transformer与注意力机制的协同效应

与早期的循环神经网络(Recurrent Neural Network,RNN)相比,Transformer架构在处理语言时更加高效和强大。RNN通过在序列中逐步传递信息来处理语言,但它们在处理长序列时容易遇到梯度消失或梯度爆炸的问题,这限制了它们捕捉长距离依赖关系的能力。例如,在处理一篇长篇文章时,RNN可能难以记住文章开头的上下文信息,这对于理解文章的整体含义至关重要。Transformer通过注意力机制解决了这个问题,它允许模型在不考虑单词之间距离的情况下,直接关注到重要的上下文信息。这意味着,无论句子有多长,模型都能有效地利用文章的开头信息来理解和生成文本。这种机制的灵活性和效率是Transformer架构成为现代语言模型首选的主要原因。通过结合海量参数和大量训练数据,Transformer和注意力机制共同成就了强大的语言模型,这些模型不仅能够生成连贯的文本,而且在很多情况下,其生成的文本与人类写作难以区分。这标志着自然语言处理技术的重大进步,也为未来的AI应用开辟了新的可能性。