具身的诱惑,机器人如何突围

作者: 荣智慧

“机器人的时代已经到来,”英伟达首席执行官黄仁勋在3月GTC大会上说,“各位请注意,这很可能成为所有行业里规模最大的行业。”

作为三年来人工智能热潮的最大赢家,黄仁勋此言一出,又给火爆的“具身智能”添了把柴。

其实,“机器人”也好,“具身智能”也好,说法不同,本身是一个尚未普及同时并不令人陌生的东西。它最早诞生于1921年捷克剧作家卡雷尔·恰佩克的《罗素姆机器人》,Robot一词就来自捷克语Robota。

剧中,机器人的制造,基于一种特殊的化学物质,工序涉及制造机器人皮肤的揉搓槽、盛载肝和脑的大桶,以及生产骨骼的工厂;神经纤维、动脉和肠脏则“纺制”于工厂的线轴。

它们可以像汽车一样组装起来。

科幻作家艾萨克·阿西莫夫很讨厌这个作品,但却肯定了恰佩克创造Robot这个词的文化价值,“这个词让所有语言的科幻小说成为可能”。同样,它在现实世界的影响力也毋庸置疑,百年来,激励无数科学家去开发一种与人类相似、具有智能,能够像人类一样行动、推理和互动的机器,融运动、感知和互动为一体,以再现人类的身体、认知和社会功能—也就是人形机器人。

正如恰佩克在序幕中提出的戏剧冲突,制造机器人,到底是为了证明“不仅神可以造物,人类也可以”,还是用来创造经济价值,机器人公司内部存在巨大的分歧。而在现实世界里,观念领域的造物冲动、商业层面的巨大诱惑,都吸引着人类对机器人的无尽想象。

在100年后的今天,AI已经普及,却囿于数字世界、只能处理信息,人们都知晓一点,这远非智能革命的终点。赋予AI这一大脑以“肉身”,让它冲破二进制世界的禁锢,参与物理现实世界的互动,才是人类的终极梦想。

但这也引出一个很暧昧的问题,机器人,为什么非得像人?

从“手臂”到“人形”

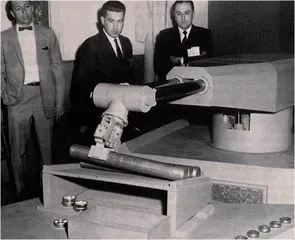

第一个现代机器人“尤尼梅特”于1954年问世,“摇篮”则是美国通用汽车制造厂。

“尤尼梅特”和艾萨克·阿西莫夫最初的设想很像。1940年代,阿西莫夫的“机器人”在火星上干活,那里条件艰苦,工作枯燥,甚至得靠心理学家解决“心理问题”。十几年后,发明家乔治·德沃尔和约瑟夫·恩格尔伯格创造了一台可编程的“尤尼梅特”,用来处理汽车厂里没人干的脏活累活—搬动上百摄氏度的模切金属部件。

现实还追不上科幻小说。“尤尼梅特”(Unitmate)没有人形,只是个“机械臂”。经过几年的测试,1961年,它成功部署在通用汽车的一家工厂里。一用上“尤尼梅特”,通用就“杀疯了”—每小时生产110辆汽车,是当时任何一家车厂生产效率的两倍多。

又过了十几年,维克多·施恩曼于1969年创造了“尤尼梅特”的进化版,也叫“斯坦福臂”。比起从磁鼓存储器里接受指令的“尤尼梅特”,“斯坦福臂”不仅靠计算机软件精细控制,还具有六个运动轴,更接近人体手臂的活动范围。

1972年,人工智能机器人出现了。因为动作颤颤巍巍,斯坦福研究所的研究人员给它起名“摇晃者”(Shakey)—给“摇晃者”下达指令,“找出房间里的障碍物”,它会使用多个传感器来完成任务。

“摇晃者”采用的是简单的计算机视觉技术。这项技术一直影响至今,在2010年代尤其发扬光大。美国电动汽车特斯拉就彻底采用“纯视觉方案”,靠摄像头而不是激光雷达来检测周围环境和物体。它可以收集数据,构建环境模型,然后使用“规划”程序生成下一步行动。这种“规划”层的设计,是机器人历史上最重要的创新之一,至今大多数机器人系统依然采用它的构思。

在1970年代末期,日本学者牧野洋开发出SCARA(也叫选择性柔顺装配机械臂),专门为拾取和放置物体而设计。

工业流水线的本质,就是将组件从一个点移动到另一个点,劲儿虽小、但速度更快的SCARA,极大提高了工业生产的效率,由此,电子装配、汽车生产、制药、食品和饮料加工以及包装和材料处理等行业,如虎添翼地发展起来。

其实,工业生产不是特别需要人形机器人,适合流水线的往往是机械臂、机械腿—只需要“像”人体的一部分就够了。近十几年流行的“机器换人”浪潮,换上来的也都是各种“机械肢体”,有些纯“运输类”机器没手没脚,靠“履带”运动。

进入家庭、和人打交道的机器,才需要做成“人形”。

走进千家万户?

20多年前,美国机器人学家辛西娅·布雷泽尔就强调,如果机器人要和人类一起工作和生活,要得到人类的信任,就必须读懂人类的情绪、表现自己的个性。

2000年,第一款社交机器人“命运”(Kismet)横空出世—为了体现“与人类打交道”的独特性,它甚至只有一个“脑袋”来传情达意。它“长”着一对富有表现力的黄色眉毛,浓重的红唇,粉色招风耳和蓝色的大眼睛,由21个电机控制,能表达从快乐到无聊等一系列表情。

音频传感器和算法,可以让它“察觉”人的反应:如果你对它大喊大叫,它会显得沮丧。如果你轻声细语,它会流露出好奇。通过创造“命运”,布雷泽尔向大众展示了机器人“应有”的魅力和表现,为日后的Alexa、Siri以及Google Home等语音助手奠定了基础。

“命运”的知名度,远不如同时期的日本本田E系列机器人“阿斯莫”(ASIMO)。阿斯莫高130厘米,重54公斤,外形酷似背着背包的太空人,能以时速6公里的速度前进。它能完成开水瓶、握纸杯、倒水的精细动作,到2012年时已经具备同时与三人对话、手指独立运动、双脚同时离地的功能。

21世纪初,一个迄今为止最成功的To C应用出现了—扫地机器人。2002年,Roomba“入侵”了人类客厅。它的创造团队iRobot成立于1990年,由麻省理工学院的研究人员组成,本来是给美国军方造机器人的。

当时美国军方需求是“排雷”,让机器人检查地雷区域,iRobot就开始研究如何在给定面积里,让机器人探索每一平方米。歪打正着,这个功能正好能扫地。2002年,Roomba成了第一款真正受到广大消费者欢迎的机器人,更用事实证明,只要足够有用,是不是人形都没有关系。

紧接着,物流机器人也在2003年出现。米克·蒙兹的Kiva机器人游走于巨大的仓库,来回查找和拾取物品。与传统的传送带系统相比,自主性的物流机器人更加灵活机动,易于使用。Kiva和Roomba长得很像,只不过后者是“底部使劲”吸尘,前者是“顶部使劲”承载物品。

Kiva彻底改变了仓储和运输的效率,带来电子商务的突飞猛进。2012年,亚马逊花7.75亿美元收购了该公司。

2004年,波士顿动力的“大狗”(Big Dog)成为YouTube观众的最爱。自打诞生起,这个黑不出溜的四足机器人,时而踱步于绿树成荫的森林,时而攀爬在60度的山坡,时而踏进齐膝深的积雪,时而跳过成堆的砖块。被人从侧面狠狠踹一脚,它也顽强不倒。

“大狗”不是自主型机器人,靠人工控制器做动作,因此也就没有视觉系统和复杂的程序。它配备50个传感器和1台计算机,用于管理步态和身体平衡。最厉害的是,只要有两只脚同时接触地面,它就可以弹跳,比其他机器人灵活多了,能适应更复杂的路况。

“大狗”也是为了物流打造的,它能翻山越岭,也能上下楼,拿点包裹捎点物件不是问题。当然,想军民两用也不难,崎岖的战场上送几件武器不在话下。

这种不走人形的智能机械路线,也延伸到了汽车里。2005年,自动驾驶汽车完成了第一次重大测试。一辆名为“斯坦利”的大众途锐赢得第二届“DARPA”挑战赛。“DARPA”是美国国防部高级研究计划局的简称,挑战赛的内容是在典型的战地场景,让汽车按照给定的路线图躲避障碍,到达安全点。

2004年第一届DARPA挑战赛没有赢家,100万美元的奖金无人认领。2005年第二届挑战赛,奖金翻了一倍,达到200万美元,路线为212公里的莫哈韦沙漠赛道。195支参赛队伍,5支跑完全程,斯坦福大学的“斯坦利”以6小时53分的成绩获得第一名。“斯坦利”获胜的秘诀是一系列技术改进:根据人类驾驶习惯训练的程序,5个激光雷达传感器识别车辆前方25米内的物体。

虽然线路是事先规划好的,障碍是静态的,所有参赛车辆也不会“碰头”,但“斯坦利”的成功证明了自动驾驶的现实可行性。自那以后,“挑战赛”的难度越来越高,车辆和环境的互动性也越来越强,自动驾驶成为汽车行业最大的愿景。

肉身未具,大脑先来

执着于“像人”的传统机器人公司,似乎陷入了迷途。

2018年阿斯莫停产,意味着人形机器人的路线还没有走通。虽然它样子很萌,也会做不少事情,但离走进家庭、真正帮人做事还有极大的距离。它的成本又过于昂贵,单台300万美元,维护一次都够买一辆小汽车的了。

波士顿动力几代“元老”机器人先后退役停产,包括双足机器人“阿特拉斯”。2021年,波士顿动力被软银收购,又被转手给现代汽车,2024年停止开发人形机器人。

2017年在沙特利雅得“未来投资峰会”上获得公民身份的机器人“索菲亚”,也不再有任何音讯。

上个时代呼风唤雨的机器人公司,已经跟不上快速崛起的AI浪潮:由于机械制造和程序设计已经逼近极限,传统机器人卡在了阿斯莫和阿特拉斯的“巅峰”上,似乎再无法前进。

2010年代初,人工智能革命悄悄酝酿,即将彻底改写机器人产业。2012年,英国人工智能专家杰弗瑞·辛顿和多伦多大学的一个团队,创建出世界上最精确的视觉识别系统,达成了人工智能领域近半个世纪来的最大进步。

第二次世界大战后,人工智能(那时候还叫“机器智能”)研究方法分裂成“剑宗”和“气宗”。一派主张“自上而下”,在机器中制定全套符号和规则以适应人类世界;一派主张“自下而上”,让机器模仿大脑“神经模型”来自动学习。20世纪六七十年代,“自上而下”派独领风骚,随即遭遇瓶颈—世界广大,背景繁杂,一对一给机器写符号规则也难以穷尽。

辛顿这一派搞的是“自下而上”,20世纪80年代开始走向“复兴”,名字也改了又改,最新的名字叫“深度学习”。2024年,辛顿获得诺贝尔物理学奖,得号“AI教父”。

辛顿训练视觉神经网络几十年。其技术底层是卷积神经网络,利用反馈来调校输出,其实就是类似于人类神经网络的多层感知系统。不同的神经层接收、处理不同的信息,层层递进,得到一个关于某事物的“正确”描述。计算机模拟这一过程,开始“学习”人的“识别”“认知”能力。

这一技术方向非常需要大量数据和强劲处理能力。移动互联网大爆发和芯片迭代带来了好机会。2012年,辛顿如愿以偿,他的程序在ImageNet比赛中脱颖而出,能识别和排序超过100万张图像,错误率仅为15.3%,比最接近的对手还高出10个百分点。