面向拔尖人才培养的大数据知识点和能力点研究

作者: 王宏志 刘显敏 史宁

[摘 要] 数据是国家基础性战略资源,大数据是拔尖人才培养必备的知识。随着我国信息化建设的突飞猛进,各行各业产生和存储了海量数据,对数据进行处理、分析、挖掘的需求愈发强烈。为了保障我国大数据产业的健康快速发展,高等学校承担着为国家培养大数据基础研究、产品研发和业务应用等各类人才的社会重任。为更好地构建拔尖人才培养体系,加强体系建设,结合当下人才培养对目前大数据相关职位进行了需求调研工作,提出了可供参考的体系建设思路,为拔尖人才培养提供了新的角度。

[关键词] 拔尖人才;大数据;知识点;能力点

[基金项目] 2021年度教育部拔尖计划2.0研究课题“面向未来技术的科技创新领军人才培养的探索与实践”(20211018);2020年度黑龙江省高等教育教学改革研究项目“面向未来技术的科技创新领军人才培养的探索与实践”(SJGY20200247);2021年研究生教育教学改革研究项目“大数据计算技术前沿”课程建设(AUDQ9802201220)

[作者简介] 王宏志(1978—),男,辽宁沈阳人,博士,哈尔滨工业大学英才学院教授,主要从事大数据和拔尖人才培养研究;刘显敏(1984—),男,黑龙江海伦人,博士,哈尔滨工业大学英才学院副教授,主要从事大数据研究;史 宁(1981—),女(满族),吉林吉林人,硕士,哈尔滨工业大学英才学院拔尖学生培养中心主任、讲师,主要从事拔尖人才培养和国际化教育研究。

[中图分类号] C961 [文献标识码] A [文章编号] 1674-9324(2022)38-0172-05 [收稿日期] 2021-10-13

大数据产业是指以数据生产、采集、存储、加工、分析、服务为主的相关经济活动以及相关信息技术服务。大数据产业是智力密集型产业,需要大量专业技术和应用人才,目前具有较全面大数据知识和技能的人才还非常缺乏,难以满足发展需要。为了保障我国大数据产业的健康快速发展,高等学校承担着为国家培养大数据基础研究、产品研发和业务应用等各类人才的社会重任。为更好地构建拔尖人才培养体系,加强体系建设,结合当下人才培养现状对目前大数据相关职位进行了需求调研工作,本文结合当前需求,提出了可供参考的体系建设,为拔尖人才培养提供了新的角度。

一、大数据职位需求

针对网络公司的职位需求,对目前大数据行业市场进行调研。虽然很多岗位有不同的名字,但职位需求基本相似,根据职位需求,将岗位分为以下五类。

(一)平台开发类

该类岗位主要进行平台开发工作。按照顺序进行进阶,最基础的职位是大数据研发工程师,进阶则是大数据平台开发工程师,最终可以到达大数据平台架构师的高度。

1.大数据研发工程师。该职位主要进行大数据平台上的应用开发,属于应用层开发。一般要求应聘人员为计算机相关专业,有扎实的计算机理论基础;熟练掌握Java、Python服务端编程,有良好的编码习惯;深入理解MapReduce,熟练使用Storm、Hadoop和Spark,并阅读部分源码;熟练使用HDFS、Hbase、Kafka、ElasticSearch和Solr;深入理解Lucene、ElasticSearch、Solr等,有优化经验者优先;具备良好的学习能力、分析解决问题能力;具有高度的责任心和团队合作精神;有大数据平台产品建设经验者优先[1]。

2.大数据平台开发工程师。该职位要求胜任大数据平台的框架方面的修改工作,需要有非常丰富的开源平台框架经验。其基本工作要求为:扎实的数据结构及算法功底,优秀的工程实现能力;熟悉Linux开发环境,精通C/C++、Java;有Storm、Hadoop、Spark、Kafka、Hbase等开源框架经验者优先;有机器学习知识背景,有实践经验更佳;优秀的分析问题解决问题能力、学习能力、团队合作意识[2]。

3.大数据架构师。该职位需要有非常丰富的工作经验,并对大数据平台有非常深入的了解,能够进行平台构建等相关开发。基本工作要求为:扎实的Java基础知识,5年以上的Java Spring研发和大型系统架构经验,熟悉分布式系统的设计和应用,熟悉大数据领域的开源产品,清楚原理和机制;熟悉Hadoop、Hbase、MYSQL等数据存储产品使用方法和特性;有基于Kylin或Greenplum等平台应用研发经验者优先;有云平台架构研发经验和5人以上团队管理经验者优先;清晰的逻辑分析和表达能力,热爱技术,乐于分享,对行业和技术的发展有自己的见解,在大数据领域内有深入的研究和积累者优先;有Spring Cloud Data Flow开发经验者优先。

(二)平台运维类

该类岗位主要进行大数据平台的运维工作。其基础为大数据运维工程师,为系统提供运维工作,其进阶为大数据运维架构工程师,负责更加复杂的运维工作。

1.大数据运维工程师。该职位主要对大数据平台进行运维工作,主要负责日常维护工作。基本工作要求为:计算机相关专业本科以上学历,2年以上大型系统运营经验。有监控和容灾的实际经验;具备发现问题、分析问题、解决问题的能力;能出具系统优化的整体解决方案;具备良好的自学能力。责任心强,有良好的对外沟通和团队协作能力;运营过Hadoop、Spark、Hive、Hbase、Storm、PostgreSQL等相关系统,有从事过海量数据分布式处理、各种分布式计算,或者分布式存储、分布式计算系统相关的工作经验。

2.大数据运维架构师。该职位需要有非常丰富的运维工作经验,并需要从系统架构层面进行运维思考。其基本工作要求为:负责分布式集群的运维,包括版本升级、系统优化、故障处理、集群监控;掌握Hadoop、 Hive、 Spark、 Yarn、 Kafka、 Hbase、 Flume、ES等组件的安装、配置、使用和优化;熟悉源码者优先;熟悉 HDP 者优先;掌握 Linux 操作系统的配置、管理及优化,能够独立排查及解决操作系统层的各类问题;熟悉至少一门脚本语言(Python/Shell),有自动化运维工具开发经验者优先。

(三)数据分析类

该类岗位主要进行数据分析方面的工作,分为大数据分析师和大数据算法工程师,其中大数据分析师主要对数据进行基础分析,而大数据算法工程师则主要通过机器学习和数据挖掘算法进行分析设计,属于更加有难度的工作。

1.大数据分析师。该职位需要运用数据分析的基本手段对大数据进行分析并生成分析报告。一般要求应聘人员熟悉各种数据挖掘算法(如逻辑回归、决策树、贝叶斯、神经网络等)及其原理,能根据业务分析专题,建立挖掘模型,选择最合适和高效的算法并实现;熟练使用R、Mahout、SPSS、SAS中某一种或多种分析软件,熟悉SQL语言;具有海量数据挖掘及分析相关项目经验,熟悉文本分类、聚类、机器学习,有相关项目经验者(互联网分析挖掘经验、文本挖掘经验,微博数据可视化和图片识别经验)优先;能跟进业务线项目的数据分析工作,完成上线前后的数据调研、效果评估等分析报告;能够根据产品运营数据,出具产品分析报告,并对产品提出优化建议

2.大数据算法工程师。该职位需要机器学习和数据挖掘的相关知识,并涉及一些算法设计相关内容。基本工作要求为:精通SPSS Clementine、SAS EM等各类型数据分析工具,能制作专业分析报告,精通统计学,数据挖掘技术,尤其是回归模型、决策树模型;熟悉常用数据挖掘算法,包括但不限于决策树、逻辑回归、支持向量机、神经网络等;有金融、通信或互联网某一行业实际数据挖掘项目经验,并对此行业业务有深刻认识;熟悉Hadoop的体系架构和运行原理,熟悉Hadoop的MapReduce原理,有使用Python、Shell、Java的MapReduce开发实战经验者优先;熟悉Java、Scala、R、Python至少一种;了解大数据框架Hadoop、Spark等。

(四)大数据科学家

这个岗位有其特殊性,既要求对数据分析有一定了解,也要求对大数据平台有一定了解。基本要求是其中一项突出,另一项需要了解并会使用。其基本工作要求为:要求具备编程、计算机科学相关专业背景。掌握处理大数据所必需的Hadoop、Mahout等大规模并行处理技术与机器学习相关的技能;除了数学、统计方面的素养之外,还需具备使用SPSS、SAS等主流统计分析软件技能;数据可视化,对数字罗列所组成的数据中所包含的意义进行分析,开发Web原型,使用外部API将图表、地图、Dashboard等其他服务统一起来,从而使分析结果可视化。

(五)产品运营类

这个岗位主要是负责产品运营,由于其与大数据相关,所以有其专业特殊性。

1.数据产品经理。需要利用大数据分析相关知识对产品进行设计,需要极强的综合能力。一般要求3年以上数据分析、数据挖掘、推荐系统等相关产品策划经验;熟悉DSP、SSP、ADX平台,了解广告RTB原理和算法;熟悉精准投放和DMP用户画像的领域知识等;熟悉广告平台运营模式,充分理解品牌广告和效果类广告的投放特点;对机器学习、概率统计、最优化算法原理有深入理解;具备较强的团队协作能力和沟通能力,思维活跃,学习能力强。

2.数据运营专员。需要利用大数据分析,进行运营体系的构建与支持,需要数据建模等相关知识。要求应聘人员可以根据公司业务发展规划,构建高效的大数据运营支撑体系,提升大数据对生产经营的支撑能力;根据生产需要,负责个性化分析应用的支撑工作,包括需求分析、口径管理、脚本开发、数据提取、数据分析等工作;基于大数据分析结果,主导用户和产品的大数据运营专项策划并组织实施,确保关键运营指标的达成;负责用户行为数据建模,主动挖掘用户特征并将结果应用于业务推广,提升业务推广的质量和效率;根据公司发展战略,主动发现运营中存在的问题,并形成大数据分析报告给公司领导或业务部门决策。

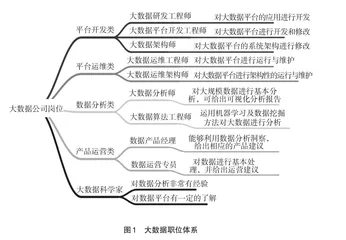

具体的职位体系图谱如图1所示。其更能直观地展示出我们的市场调研结果。

二、课程体系

大数据的兴起与众多领域的大型数据集的出现直接相关。科学、社会科学、商业、人文和工业都在产生前所未有的原始数据或结构化数据。数据量的增长导致我们通常无法在没有自动化软件的帮助下进行直接有效的人工分析。大数据是将计算机科学领域和用于询问数据提取有用信息的统计领域汇集在一起的新兴学科。多领域交叉学科对课程体系设置有了新的要求。

我们根据每个职位的要求,整理出能力点,并根据其具体需求,整理出知识点,根据知识点,结合ACM DSTF中推荐的相关课程体系设置课程,通过对知识点的总结和归纳,使课程在符合学生学习能力的合理可接受范围。我们将课程分为6大部分。

(一)计算机基础课

数据科学严重依赖计算和计算设备:收集和存储数据,了解数据的数字表示影响精度的方式,以及不同处理器类型和配置如何影响计算效率的方式,了解在处理过程中存储和移动数据。由于大数据专业学生将与其他系统进行交互,因此他们应该能够开发能够独立或与现有软件和/或工具集成的程序。鉴于它们在许多数据科学应用中的作用,对矩阵表示和操作给予了特殊的要求。该类课程为基础必修课,主要为学生建立牢固的计算机知识体系。主要包括程序语言设计:Java基础开发、C++、Python基础开发(二选一)、计算机系统、数据结构与算法、数据库系统、计算机网络、软件工程等课程。对应职业需求中语言类、计算机基础类需求,如:Java基础扎实,熟悉io、多线程、集合等基础框架;熟悉分布式、缓存、消息、搜索等机制;了解Sring MVC等框架;了解计算机网络;具有防火墙、入侵防御、VPN等网络安全系统的应用经验等。

(二)数据科学基础课

该课程为大数据方向的基础课程。在我们日益依赖各种形式的决策数据的数量和质量时,大数据专业学生负有保护数据完整性和正确使用数据的道德责任。数据挖掘的核心是处理、分析和呈现数据,以获得有价值的信息。分析的基本类型包括聚类、分类、回归、模式挖掘、预测、关联和异常值检测,并注意各种形式的数据,包括时间序列数据和Web数据。该接口的质量显著影响所有形式的可用性,并包括广泛的技术:动画、可视化、模拟、语音、视频、识别(人脸、手写等)和图形。这部分课程包括统计语言编程:R语言编程、应用统计、数据挖掘、实用机器学习、数据管理、数据分析与管理建模、数据可视化等课程。修读完该部分课程,学生将具备基础的数据分析能力,明晰基础的数据分析流程。满足职业需求中“了解数据挖掘算法如逻辑回归、决策树、贝叶斯、神经网络等及其原理,能根据业务分析专题,建立挖掘模型,选择最合适和高效的算法;熟练使用统计工具;熟练使用数据分析工具:熟练使用R、Mahout、SPSS、SAS中某一种或多种分析软件,熟悉SQL语言;熟悉Java、Scala、R、Python至少一种;精通SPSS Clementine、SAS EM等各类型数据分析工具,能制作专业分析报告”等要求。有助于从事数据分析师、数据运营专员等一系列基础数据岗位。