强化学习在决策分析类课程中的教学探索

作者: 王天宇 杨敏

[摘 要] 近年来,强化学习不断成为研究和应用的热点话题,受到广泛关注。考虑到强化学习与决策过程分析的紧密关联,将强化学习纳入决策分析类课程成了一个不可忽视的需求。探讨如何在“决策分析导论”中融合强化学习模型的方法。与传统“机器学习”和“强化学习”课程不同,教学策略强调对概念的理解,减少公式复杂性,更多地展现其实际应用和案例,如AlphaGo、MIT机器狗等热门话题,以增强学生的学习兴趣。特别是通过改良的寻宝游戏示例,进一步深化学生对智能体与环境交互的认知。这种教学探索不仅丰富了课程内容,还为管理类教学方法带来了创新,期望更好地培养新一代决策者。

[关键词] 强化学习;决策分析;教学模式;课程改革

[基金项目] 2021年度北京航空航天大学经济管理学院课程团队建设项目“决策分析”(KCTD-2021-JCFX);2023年度北京航空航天大学工业工程专业一流专业建设项目;2022年度北京航空航天大学研究生教育与发展研究专项基金“促进知识共享的工程项目管理课程教学设计——一种激进建构主义的视角”(JG2022006)

[作者简介] 王天宇(1990—),男,山东东营人,博士,北京航空航天大学经济管理学院讲师,主要从事行为运筹学研究;杨 敏(1975—),男,江西乐安人,博士,北京航空航天大学经济管理学院副教授(通信作者),主要从事风险和决策分析与项目管理设计研究。

[中图分类号] G642.0 [文献标识码] A [文章编号] 1674-9324(2024)36-0001-04 [收稿日期] 2023-08-23

强化学习(reinforcement learning)是蓬勃发展的深度学习在决策分析领域的新兴方向。通过模拟代理在动态环境决策中持续试错学习优化策略以最大化预期收益的方法,应对实际问题中的不确定性、复杂性,并为决策制定提供更精准、灵活的解决方案,推动决策分析领域的实践与创新。强化学习在自动驾驶、智能游戏及金融投资等领域中被广泛应用,用于训练智能体在复杂环境中不断调整决策,实现最优化的行为策略。同时,为引导高等学校瞄准世界科技前沿,不断提高人工智能领域科技创新、人才培养和国际合作交流等能力,为我国新一代人工智能发展提供战略支撑,2018年4月教育部印发了《高等学校人工智能创新行动计划》。虽然“机器学习”课程建设已经得到了快速发展[1],但强化学习在决策分析领域内容的结合的探索仍然较少。本文以高等院校管理类课程“决策分析导论”为例,介绍在管理类研究生课程中引入强化学习的尝试和探索,分析并提出针对管理类课程教学方法改革的一些措施。

一、课程建设背景

(一)“决策分析导论”课程现状

决策分析(decision analysis)研究如何在不确定性条件下做出理性的决策。它基于主观概率论和效用理论,提供了一套完整的公理系统指导决策[2],包括规范决策(应该如何决策)和描述决策(人们实际如何决策)两大领域[3]。“决策分析导论”课程现阶段内容是决策分析领域的基础知识,包括决策陷阱、理性决策行为、不确定情况下的决策分析、多属性决策分析以及多人决策分析等内容,旨在培养学生在复杂决策环境下的分析能力和决策能力。其知识背景发展始于20世纪中叶,随着不同学科的融合和技术的进步,这些概念逐渐深化和应用于实际决策问题中,如多属性决策分析的发展与决策分析和运筹学的交叉有关,起源可以追溯到20世纪中叶。层次分析法(analytic hierarchy process, AHP)由美国运筹学家托马斯·塞蒂(T. L. Saaty)于20世纪70年代中期提出,而TOPSIS法和其他多属性决策方法则在随后的几十年中逐步发展完善。期望效用理论是20世纪中期出现的概念,由诺贝尔经济学奖获得者冯·诺依曼和约翰·纳什等人发展起来。针对“决策分析导论”课程的教学改革包括挖掘该课程中的思政元素,或引入Excel等工具辅助决策[4-5]。

(二)强化学习

强化学习是一种试错的机器学习方法,通过智能体与环境的互动来学习。智能体根据其动作从环境中获得反馈,然后利用这些反馈更新其知识和经验在未来做出更好的决策。强化学习属于机器学习技术的一部分,但与监督学习、非监督学习等其他方法有所不同。强化学习的学习过程中没有预先提供正确答案,而是通过奖励反馈和实验试错来学习。这种学习过程具有延时性,智能体的动作会影响后续的环境反馈。强化学习是一个与时间序列相关的过程,涉及序贯决策的制定。随着深度学习模型的发展,深度强化学习技术将深度学习与传统强化学习相结合,实现了对复杂环境的更好表征。这种技术在自动驾驶、机械臂控制等复杂场景中有重要应用。著名的深度强化学习应用之一是谷歌DeepMind于2016年开发的AlphaGo程序,通过强化学习在围棋领域取得了突破,先后战胜了围棋大师李世石和柯杰。这一成就引起了广泛的关注,也使深度强化学习开始受到更多学生的关注。此外,深度强化学习技术还在生物工程、机械制造、化学分析、药物合成等领域有应用,能够推动各个需要决策支持的学科的发展。

二、基于强化学习的计算机辅助决策内容教学探索

(一)教学内容重点和难点

因大多数高校开展了机器学习、人工智能类相关课程的教学工作,学生对从监督学习、非监督学习到强化学习都有概念性的涉猎。特别是强化学习,一般不作为重点内容学习。此外,由于“决策分析导论”课程面向管理类专业方向研究生,学生在本科阶段所选择的相关课程,如“机器学习导论”“数据挖掘导论”等前导课程以浅尝辄止的科普类教学为主。学生通常“知其然而不知其所以然”,甚至未必“知其然”。这是因为,作为机器学习和决策科学的交叉,对强化学习的理解本身需要扎实的基础知识。不仅包括管理类本科课程“概率与统计”“最优化方法”等,也包括学生较为薄弱的“随机过程”。此外,对机器学习的深入理解,需要学生有对算法和计算复杂性理论的深刻理解。例如,强化学习本身作为一种启发式算法(heuristic algorithm),其优势在于较小的计算复杂度和出色的表现。然而,大部分学生并不清楚如何度量计算的复杂度和启发式算法的表现。总之,差异化较大的前导课程教学背景和薄弱的算法相关理论基础,成了在“决策分析导论”课程中引入强化学习的教学难点。

(二)面向管理类学生的教学设计

面向管理方向学生差异化较大的前导课程教学背景和薄弱的算法相关理论基础的特点,为了保证不同背景的学生可以在课程学习过程中有较好的收获,笔者采用基础扎实、前沿引领、实验丰富、循序渐进的教授方式。具体方式如下。

1.前导课程知识的简要补充。针对差异化较大的前导课程教学背景这一特点,有必要为学生进行前导知识的补充和铺垫。这对没有选修过相应课程的学生来说,其与强化学习之间的逻辑关系并不明确。因此,不同于其他课程回顾性地介绍背景知识,“决策分析导论”课程既要把背景知识当作新知识来讲,又要主次分明、结合本课程的教学特点。例如,在介绍机器学习基础理论时,“决策分析导论”课程选取决策树和人工神经网络作为重点,其他模型,甚至非监督学习(unsupervised learning)仅做简要提及或忽略。决策树本身可作为监督学习(supervised learning)的代表性算法,其具有良好的可解释性,更易于理解和讲授,而作为“决策分析”课程内容,在此过程中有必要向学生阐述清楚“决策树”这一名词在决策分析方法和机器学习模型中代表不同的含义:在前者中,决策树作为决策主体用于风险决策以最大收益期望值或最大效用期望值为原则进行决策分析的工具,其每个节点代表一个决策点(decision)或一个事件点(event);而在后者中,决策树并不是决策主体使用的工具,而是机器学习进行有监督分类(classification)的模型,所谓的“决策”其实是计算机的决策,更确切地说,应为“判断”。

通过以上解释,提前规避了学生在今后科研或学习过程中接触“决策树”这一模型,与“决策分析导论”课程以及运筹学中的“决策树”可能产生的混淆。

2.模型抓重点,少公式、多讲解。在介绍强化学习模型时,紧扣与“决策分析导论”课程之间的相关性和与“机器学习”“强化学习”这些专业课之间的差异化。“决策分析导论”课程整体以概念、方法和理解为主,涉及的公式推导较少。在笔者的教学经验中,在介绍机器决策和机器辅助决策时突然引入大量公式推导会导致学生理解困难,以及后续注意力无法集中。为此,笔者仅保留无法规避的公式,如贝尔曼方程(Bellman equation)等。

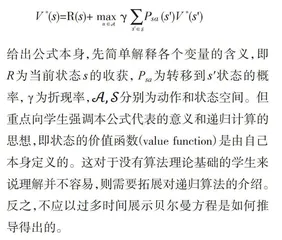

给出公式本身,先简单解释各个变量的含义,即R为当前状态s的收获,Psa为转移到s'状态的概率,γ为折现率, 分别为动作和状态空间。但重点向学生强调本公式代表的意义和递归计算的思想,即状态的价值函数(value function)是由自己本身定义的。这对于没有算法理论基础的学生来说理解并不容易,则需要拓展对递归算法的介绍。反之,不应以过多时间展示贝尔曼方程是如何推导得出的。

3.突出应用和案例。在教学中引入大量的应用实例讲解,这得益于强化学习广泛的应用属性和话题属性。例如,学生从自媒体、社交媒体广泛地了解关于AlphaGo如何战胜人类围棋大师,以及美国麻省理工学院(MIT)设计的机器狗如何通过训练从走路摔倒到熟练完成跑跳动作等新闻。“决策分析导论”课程将重启AlphaGo、MIT机器狗等具有热度的话题,让学生对其模型、训练过程和算法有更深入的理解。此外,介绍单智能体强化学习经典算法DQN最早成功应用于雅达利(Artari)游戏,其趣味性和娱乐性有效吸引学生注意力和课堂专注度。在此过程中为了深化学生对强化学习中智能体与环境的探索交互过程的认知,笔者采用改良的经典寻宝游戏(robot in a room),通过讲述强化学习算法Double DQN如何在寻宝游戏中学习、反馈和决策,培养学生泛化这一过程的能力。

寻宝游戏是广泛应用于强化学习教学中经典的例子,如Carnegie Mellon University的10-601B和University of California, Berkeley的CS188。一个机器人在地图中采取某种移动策略以达到某个目标地点并获得最大收益,如图1所示。该经典例子是确定性问题(deterministic),即若机器人采取某个移动行为,则必然导致相应的移动结果。笔者在教学中发现经典版本的问题过于简化决策环境,学生完全无法体会为何以马尔可夫决策过程(Markov decision process)建模。此问题以基于规则(rule-based)的策略就可以迎刃而解,即“总是通往目标地点的最短路径”。为此,笔者将此例改为随机环境,即解释为“机器人所在环境有频发地震,在机器人选择左行时,有80%的概率在下一时刻到达左方,也有10%的概率启动失败,和10%的概率因地震而偏移至下方”。这令问题更接近现实情况,也更适用于MDP模型,让学生对随机问题决策和混合策略有更具象的理解。

结语

强化学习在决策分析领域蓬勃发展,通过试错学习优化策略以应对实际问题的不确定性和复杂性。在管理类课程中引入强化学习,笔者通过补充前导知识、突出模型应用和案例,提高了学生的学习兴趣。尽管面临学生背景差异和算法理论难点,创新的教学设计使强化学习融入课程,为学生提供了更丰富的学习体验。这一探索为管理类课程的教学方法改革提供了启示,有望助力新一代决策者在复杂决策环境中取得更好的效果。

参考文献

[1]李君,陈万明,董莉.“新工科”建设背景下人工智能领域研究生培养路径研究[J].学位与研究生教育,2021(2):29-35.

[2]BIER V M , FRENCH S. From the editors: decision analysis focus and trends[J].Decision analysis,2020,17(1):1-8.

[3]KEENEY R L , SEE K E , VON WINTERFELDT D. Evaluating academic programs: with applications to US graduate decision science programs[J].Operations research,2006,54(5):813-828.