人工智能治理原则的实践导向:可靠性、问责制与社会协同

作者: 周江伟 赵瑜

收稿日期:2023-05-09

作者简介:周江伟,浙江大学传媒与国际文化学院博士研究生;赵瑜(通信作者),新闻传播学博士,浙江大学传媒与国际文化学院教授、博士生导师。

基金项目:国家社科基金一般项目“人工智能时代的传播伦理与治理框架研究”(编号:20BXW103)。

①Wallach W. and Marchant G.E., “Toward the Agile and Comprehensive International Governance of AI and Robotics”, Proceedings of the IEEE, vol.107, no.3(March 2019), pp.505-508.

摘要:人工智能的迅速发展与应用带来了难以避免的治理缺口。为了寻求敏捷治理,全球范围内陆续出台了一批具有“软法”性质的治理原则。通过对88份原则文本的整合与分析,聚焦其中的实践准则,研究发现在激增的文本和多元化的主张下,存在着一个公共的问题域:人工智能系统应该满足怎样的技术特性?应该如何应对技术的社会后果?应该以怎样的社会组织形式开展治理实践?尽管围绕这些问题不同原则的主张之间仍然存在张力,但不可否认,当下人工智能治理领域已经形成了一个具备共识基础的行动框架。基于文本分析,众多原则条目可以归纳为三项实践准则:可靠性原则、问责制原则和社会协同原则,它们分别回应了上述问题。其中,可靠性原则和问责制原则设定了构建符合期望的技术系统、应对技术的社会后果这两组相互补充的治理目标,而社会协同原则探讨了怎样的社会行动结构能够支持和保障这些目标的实现,三者构成了人工智能治理的行动框架。

关键词:人工智能;治理原则;可靠性;问责制;社会协同

中图分类号:TP18文献标志码:A文章编号:1007-9092(2023)05-0111-017

一、通过原则治理:从伦理声明到行动框架

随着人工智能技术的迅速发展与应用,如何实现对人工智能的有效治理成为国际社会面临的共同问题。技术变革与制度调适之间存在的步调差异①造成了不可忽视的治理鸿沟,对现有的监管体系和治理结构提出了严峻的挑战。制度调适有着明显的滞后性。现有的立法、监管和司法框架往往基于一种静态的社会和技术观点,Marchant G.E., “The Growing Gap Between Emerging Technologies and the Law”, International Library of Ethics, Law and Technology, vol.7, no.1(April 2011), pp.19-33.对于可能出现的变革缺乏预见性和灵活性。而即便公共部门能够以某种方式迅速响应,及时为新兴技术制定和调整法规,也可能因为无法充分预测技术的发展趋向而产生阻滞创新或强化风险的负作用,或是在“墨水没干的时候”就已经失去现实效力。不过,正如美国前最高法院首席大法官沃伦·伯杰所说,“应该理解,完全跟上科学的步伐并不是法律的作用和功能”,Burger W.E., “Reflections on Law and Experimental Medicine”, UCLA Law Review, Vol.15, no.2(February 1968), pp.475-493.法律系统在设计上被赋予了保守性,其关键功能之一就是在快速变革中维系社会稳定并提供制动能力。Van Alstine M.P., “The Costs of Legal Change”. UCLA Law Review, vol.49, no.3(February 2001), pp.789-871.

为了填补持续存在且难以避免的治理缺口,在人工智能领域,通过“原则”进行治理成为一种趋势。在过去的几年里,出现了大量被冠以“原则”“指南”“战略”的文件,它们由不同的行动者撰写并发布,在极短的时间内井喷式地出现在公共领域。这些文本围绕如何对人工智能的部署和应用进行有效治理,提出了一系列纲领性的建议和要求,这些文本往往是倡议性的,也有着较高的抽象层次。一些学者将这类实践统称为对人工智能治理的原则方法(Principled Approach)Mittelstadt B., “Principles Alone Cannot Guarantee Ethical AI”, Nature Machine Intelligence, vol.1, no.11(October 2019), pp.501-507.或原则主义(Principlism)路径,Seger E., “In Defence of Principlism in AI Ethics and Governance”,Philosophy & Technology, vol.35, no.2(April 2022), p.45.因而在下文中,我们也将这些文本统称为“原则”。相较于由国家强制力保障实施的、结构完整且规范清晰的“硬法”,这些原则文本往往被归类为“软法”。

“软法”是指那些效力结构未必完整,缺乏强制力和执行力保障,但能够在社会运转过程中发挥实效的规范。罗豪才、宋功德:《认真对待软法》,《中国法学》,2006年第2期。相对于“硬法”,“软法”具有更好的敏捷性,往往可以绕开官僚机构的流程和授权限制,较快地实现应用和修订。尽管“软法”缺少直接的执行力,但通过保险、行业协作、媒体监督等方式实现了间接执行,Marchant G.E., “‘Soft Law’Mechanisms for Nanotechnology: Liability and Insurance Drivers”, Journal of Risk Research, vol.17, no.6(February 2014), pp.709-719.能在“硬法”缺位的情况下发挥一定的现实效力。而“软法”在经过实地测试后具有被纳入政府监管体系的潜力,因此“软法”也被视为在必要时颁布“硬法”的准备阶段。

这些具有“软法”性质的原则文本,往往是伦理声明和实践准则的混合体。其中,伦理声明注重价值理性,回应着一系列价值问题,包括珍视谁的价值(价值立场),珍视何种价值(价值目标),如何正确对待有价值的事物(正义原则),特别是如何对其进行合理的分配。赵瑜、周江伟:《人工智能治理原则的伦理基础:价值立场、价值目标和正义原则》,《浙江社会科学》,2023年第1期。而实践准则通常基于实践理性,关注通过怎样的手段或行动方式来实现给定的伦理目标。由于这些原则在发布时通常将伦理声明内容置于首位,学术界在讨论这些文本时,也表现出对伦理问题的关注倾向。虽然这些伦理声明积极地回应了人工智能技术引起的伦理争议,为社会成员识别并概念化伦理挑战提供了共同话语,帮助缺乏系统伦理学知识的人形成道德判断。但是,仅仅建立有关技术的伦理期望或评估技术的道德后果还不足以帮助我们实现期望或应对后果。伦理学反思的中心目标不是“从外部”评价技术的发展,而是“从内部”伴随技术发展。Verbeek P.P., “Designing the Public Sphere: Information Technologies and the Politics of Mediation”, the Onlife Manifesto, edited by Floridi L., Berlin: Springer Nature, 2015, p.223.一味地进行伦理承诺可能使原则文本成为“道德的遮羞布”和利益相关方的“避风港”,用于回避真正的问题。

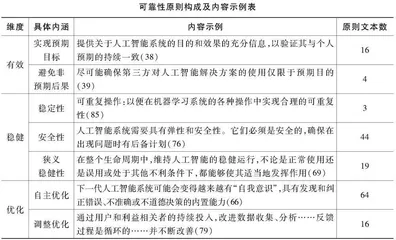

为了在伦理声明和治理实践之间搭建桥梁,使原则成为具有操作性的治理工具,本研究将聚焦于原则文本中的实践准则。通过对原则文本的分析,研究发现对人工智能进行治理的实践准则可以归纳为三项:可靠性原则、问责制原则、社会协同原则。它们分别回应了三个有关治理实践的问题:一是能够胜任伦理期望的技术系统应该具备怎样的品质;二是如何应对技术的社会后果,特别是那些非预期的后果;三是应该以怎样的社会组织形式开展治理实践。

二、研究方法

研究涉及的原则文本具有“软法”性质,与其敏捷性和过渡性相伴而来的,是文本形式的灵活性和多样性。这意味着我们的研究对象是一个构成复杂、边界模糊的合集。许多研究也是采用更加务实与灵活的方式,即通过给出示例、沿用惯例或说明共有特征来说明研究对象的范围。例如曾毅等人在“连结人工智能原则”中对研究范围的描述:“我们将研究限制在与人工智能治理有关的不同原则,包括指南、准则和倡议。这些原则通常被逐项列举,表达提议者对人工智能的理解、开发和利用的价值观和态度。”Zeng Y., Lu E. and Huangfu C., “Linking Artificial Intelligence Principles”,arXiv preprint: 1812.04814(December 2018).本研究在搜集和筛选文本的过程中也延续了这样的方式。研究涉及的原则文本具有以下特征:(1)以如何对人工智能的部署和应用进行治理为主题,有时针对特定的应用领域(如劳动、司法、金融等)或核心要素(如数据、机器人、算法等);(2)通常以清单化的方式逐项列出建议和主张,这意味着它们通常是多条原则的集合而不是对单一事项的陈述;(3)在形式和性质上区别于正式的、具有强制约束力的法律、法规和政策,通常是发布者对自身态度的公开表达和对特定事项的公共倡议;(4)内容具有较高概括性和一定的抽象水平,通常以短句、短语或关键词表达核心意旨并随附一段内容阐释。

为了尽可能全面地搜集文本,研究组合检索了三类数据源,分别是主题数据库、元分析文献和互联网搜索引擎。具体而言:首先,发现并检索三个人工智能治理的主题数据库,分别是: “AI Governance Database”“AI Ethics Guidelines Global Inventory”“Linking Artificial Intelligence Principles”。将检索范围设定在2010年后,通过对数据库中收录的文本进行逐一查阅,依据上文所述特征进行判断,筛除不符合条件的文本后形成文本清单。其次,发现了三篇有关人工智能治理原则的元分析文献,Hagendorff T., “The Ethics of AI Ethics: An Evaluation of Guidelines”, Minds and Machines, vol.30, no.1(February 2020), pp.99-120.Jobin A., Ienca M. and Vayena E., “The Global Landscape of AI Ethics Guidelines”,Nature Machine Intelligence, vol.1, no.9(September 2019), pp.389-399.Floridi L. and Josh C., “A Unified Framework of Five Principles for AI in Society”, Machine Learning and the City: Applications in Architecture and Urban Design, edited by Carta S., Hoboken: Wiley, 2022, pp.535-545.根据它们给出的文本清单进行了整合、对比和补充。最后,根据从主题数据库和元分析文献中获得的文本名称,确定了一个检索关键词清单,在谷歌搜索进行补充检索。这个关键词清单主要由两类构成,其一是主题性的关键词,包括“人工智能”(Artificial Intelligence,AI)“机器智能”(Machine Intelligence, MI)“算法”(Algorithm)“机器学习”(Machine Learning)等,其二是描述文本性质的关键词,包括“原则”(Principle)“准则”(Code)“指南”(Guideline)“宣言”(Manifesto)等。在检索过程中,分别组合使用两类关键词,在输入搜索指令时,通过“OR”连结同类关键词,“+”连结两类关键词,以实现组合检索的目标。其中,检索以英文和中文分别进行。检索前清除浏览器cookie文件,并采用无痕模式确保此前的使用记录不会影响检索结果;检索时间也被设定在2010年之后,检索的结果选项为“所有结果”(模糊匹配);对检索结果的前15页链接进行人工访问和筛选。此外,前述数据库中存在一些无法访问的链接时,研究也相应地根据其文件名称和关键词进行了补充检索。在检索完成后,我们对结果进行比对,在去除无关项和重复项后,获得了88份原则文本。具体文本参见后文附表,研究遵循三篇元分析文献的惯例,将研究涉及的原则文本在附录中逐一列出,既为本研究的结论设定了边界,也以开放的态度接受其它潜在文本的检验。